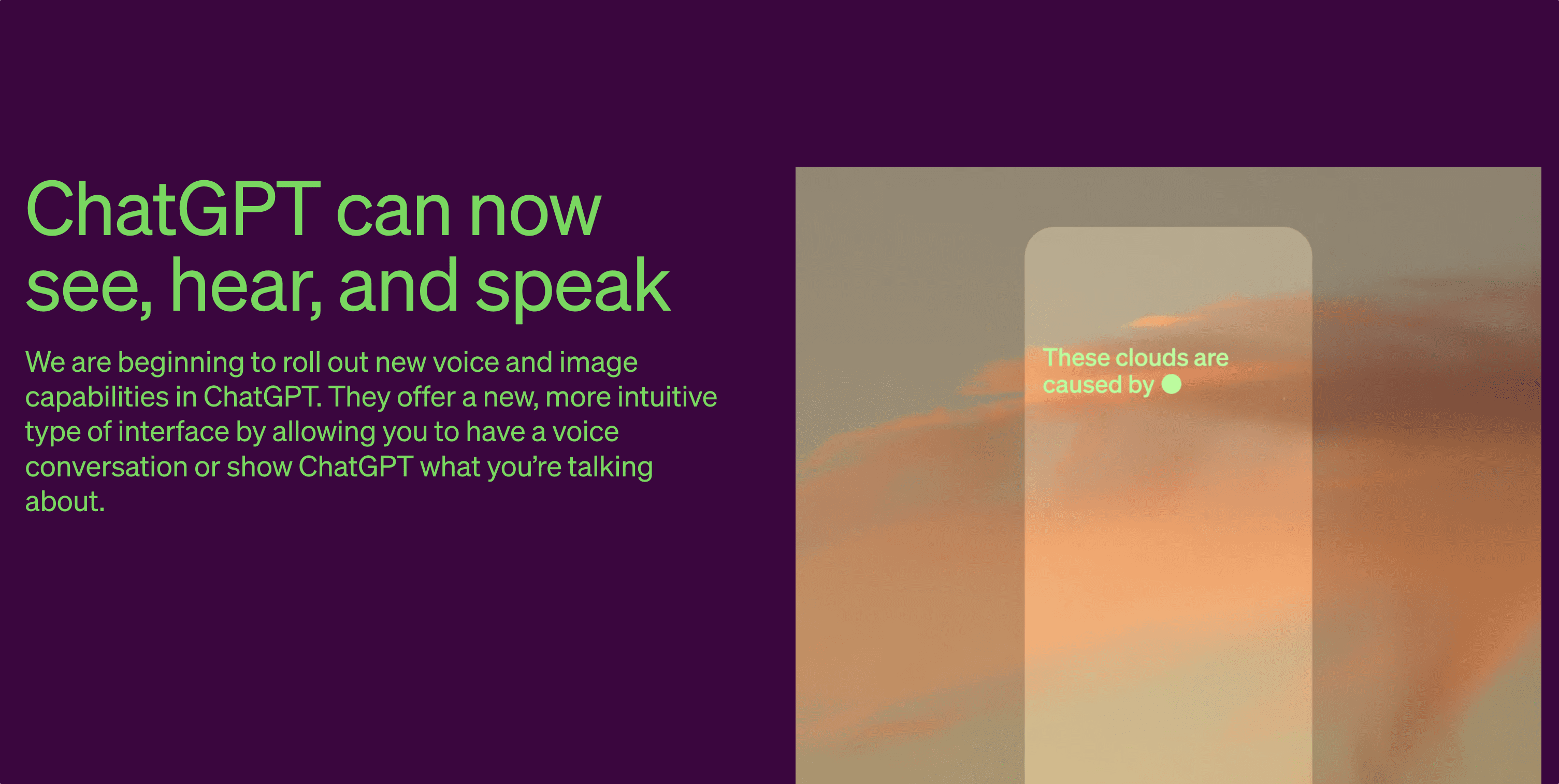

9月 25 日,OpenAI 在其官网宣布为其 ChatGPT 产品新增语音对话和图像对话功能。

10 月 19 日,OpenAI宣布图片生成模型 DALL·E 3 对所有Plus 用户开放。

短短一月不到,从文字到语音、图片,ChatGPT 这个当下最热门的 AIGC 应用,悄悄完成了向多模态的华丽变身。

多模态是什么?为什么 AI 厂商都在追求多模态?对于普通用户而言,ChatGPT 的新功能赋予了它哪些新的角色?

能看懂图片的多模态模型牛在哪?

暂且抛开「多模态」的定义不谈,我们就来说说大模型「看懂图片」这件事。

还记得你第一次听说 GPT-4 是什么时候吗?

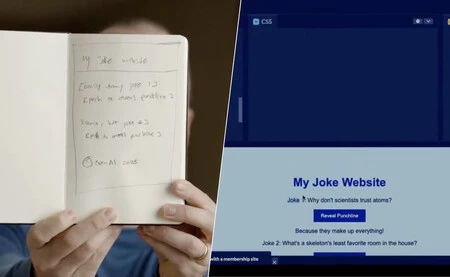

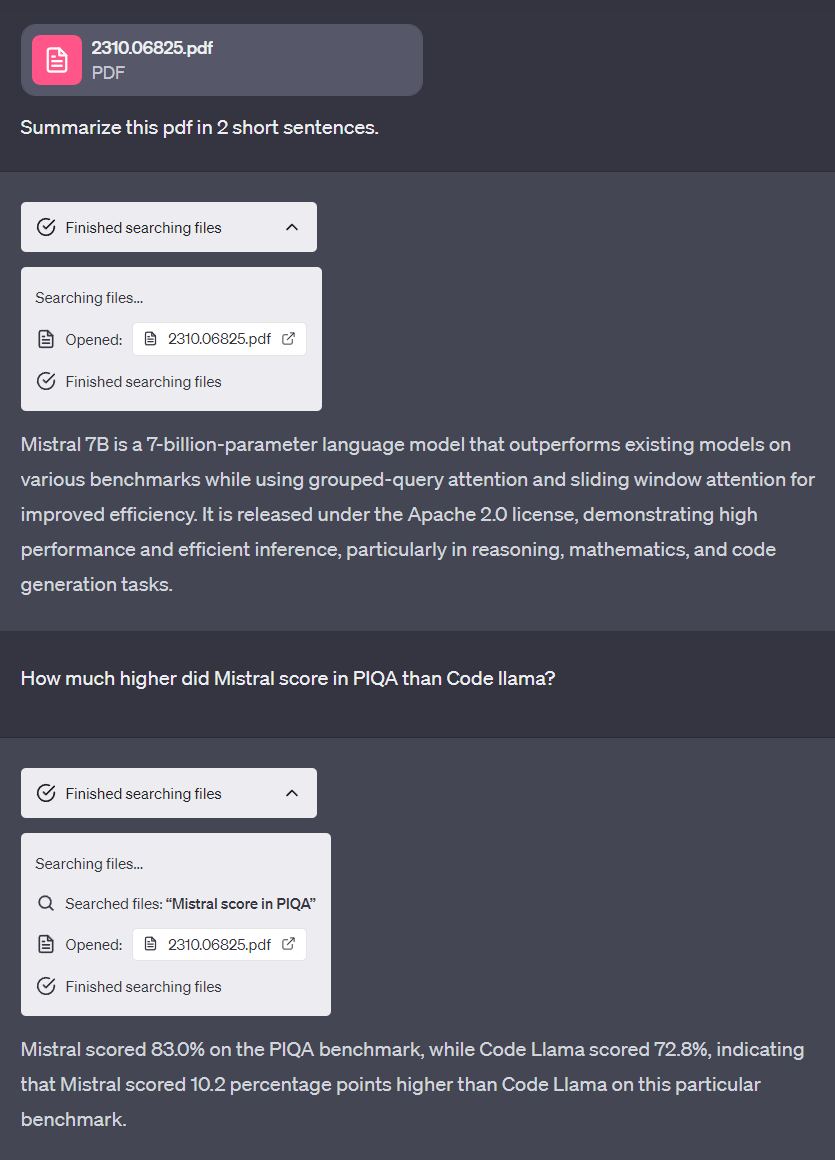

距离 OpenAI 在3月14日发布GPT-4 模型,已经过去了将近半年的时间。发布会上,最令人影响深刻的莫过于 GPT-4向世人展现的超强的多模态能力。通过纸上手绘的草图生成完整的网页代码,这要求AI 模型不仅「看得见」,更要「看得懂」。

这和我们常见的 OCR 方式不同。

原有的让大模型「看见」图片的方式,是先将图片进行光学字符识别(OCR),再将识别出的字符传递给大模型。然而,光学字符识别只能得到对应的字符,撑死也就包含字符在图片中的位置信息,对于非字符信息,自然是无能为力的。

比如上图的手绘草图生成网页代码的例子,大模型首先要分析图片,辨认出位于本子上的草图以及上面的文字和框架,再根据要求,把草图的排版还原到网页代码中。这种对图片中抽象信息乃至整体的理解能力,是原有的 OCR 方案所不具备的。

那么,我们难道从来没有过识别图片内容的模型吗?

当然不是。

曾经有视频博主测试过各家手机厂商的无障碍辅助功能,发现一线厂商大都会为视障人士提供物体识别功能。打开摄像头,软件可以分析取景框中的画面,并用相对自然的语言为用户描述。比如「白色的桌子上有个红色的苹果」之类。

然而,这类「目标检测」算法,哪怕加上 OCR技术,也很难达到 GPT-4V(带视觉功能的 GPT-4 模型)的震撼效果。

咱们来举个例子。

这张图片,从远处看很容易看出在交错的楼房和道路当中,有「YXZ」三个字母。

但是不管是 OCR 还是目标检测,传统的图像识别方案对于这个信息都显得无能为力。[1]因为这既不是明确的某几个物体的组合,也不是清晰可辨的字符。

你一定试过把一大段排版错乱、甚至错别字连篇的抽象至极的 OCR & Ctrl+V 产物丢给 ChatGPT,而在大多数情况下,大模型表现出的理解力一定比你强多了。

因为,基于海量互联网文字和图像数据训练出来的视觉-大语言模型们,天生就具有理解抽象输入的能力。

ChatGPT+自然语音=?

语音对话功能作为一个意料之外的新功能,目前只在移动端上可用。但几乎每一个体验过 ChatGPT 的语音对话功能的用户,都会被机器合成的声音的逼真度深深震撼到。不同于高德里头的志玲姐姐,语音助手需要与人类拉近距离,因此更需要的是一副「像人类」的声音。在这方面 Siri 做得很早,但也没啥长进。后来的小爱小布小艺,早已有了超越 Siri 的自然度。

这类把文字转为声音的技术,就叫做 TTS(文本转语音)技术。能把 TTS 做得自然、做到以假乱真,就代表着技术力的强大。这其中最有代表性的莫过于营销号的配音。

给你放一段营销号视频,你能不能确定这配音是真人还是机器?实际上,在当下一些先进 TTS 技术的加持下,让机器合成出逼真的人声不是什么难事,只是大多数营销号连先进的 TTS 都舍不得用罢了。关于先进的 TTS 可以做到什么程度,视频博主LKs 就做过 一期体验 ,你可以去试着分辨一下。

那么 ChatGPT 的 TTS 又有什么亮点呢?答案在于“不完美”。

给你拿一篇全是拗口专业词汇的稿子,你肯定不能保证一次性流畅地读出来,毕竟人非圣贤,孰能不读错。但是我们随便翻看营销号的 TTS 技术生成的视频,一定是没有一个卡壳,没有一个错字的。机器不会犯错,因为每一个字对应的读音都是编码在程序里的。TTS 做的只是把它们合起来。

但是 ChatGPT 做了一件前无古人的事情,让机器像人一样「学会犯错」。

如果你体验过 ChatGPT 的语音对话功能,你一定会关注到 ChatGPT 会在回答中加入语气词、停顿、语速变化甚至结巴这种普通人真实交流时常见的特征。当你闭上眼睛,听着这只带有一点新加坡口音的 AI 和你聊天,你大概会理解 ChatGPT 的语音合成技术的优越。

当然,出于不知道什么原因,当前版本的 ChatGPT 在使用中文进行语音对话时,生成回答通常需要五秒甚至更久,这一不连续的体验使得语音对话功能对于中文用户而言并不具备过高的实用价值。不过既然英语正常,那么中文也有望在以后获得同样的响应速度。

关于 OpenAI所使用到的 TTS 技术是何方神圣,笔者目前在互联网上找不到 OpenAI 提供的任何公开资料。但是就 OpenAI 和微软的合作关系而言,这一技术很有可能是利用 Azure 现有的 TTS 底座模型加上基于 ChatGPT 的SSML(语音合成标记语言)实现的。[2]

没完没了的「前额叶摘除手术」

「前额叶摘除手术」其实是网友们对于 AI 厂商出于安全考虑,为大模型设置过多限制使其看起来智商降低的一种戏谑说法。

还记得微软的 New Bing 吗?2023 年 2 月,微软发布了基于 GPT-4 模型的 New Bing,一时间引起世界震撼。

然而,纽约时报的作者在与 New Bing 进行了一次深入对话以后,发布一篇题为「A Conversation With Bing’s Chatbot Left Me Deeply Unsettled(与必应聊天机器人的对话让我深感不安)」的文章[3] ,讲述了 New Bing 从热情回答到自由发挥,最后展现出所谓「感情」的令人震惊的过程。

文章发布后不久,微软就宣布了 New Bing 每次对话最多不超过 5 轮等限制。与此同时,众多网友也发现原先健谈的New Bing越来越多地直接拒绝回答某些问题。

GPT-4V 的研究和微调过程同样是在这种保守的安全原则的指导下进行的。

根据网上的未经证实的说法,OpenAI 在 2022 年1 月就完成了 GPT-4V 模型的训练,其与 GPT-4 模型训练完成的时间是非常接近的。在训练完成的这一年多时间里,OpenAI 一直在致力于改善模型的幻觉现象和安全性。

一个公开的例子是和Be My Eyes的合作。Be My Eyes是一个通过摄像头为盲人提供远程志愿服务的平台。今年 3 月,几乎和 GPT-4 的发布同时,OpenAI 宣布他们开始与Be My Eyes共同测试并改善 GPT-4V 模型。

有参与了此次小范围测试的志愿者表示,OpenAI 应该是想借与Be My Eyes的合作,提高GPT-4V的 OCR 能力和识别真实人物的能力。(事实上,最终实装在 ChatGPT 中的 GPT-4V 模型的确具有卓越的英语 OCR 能力和过于卓越的辨别真人图片并且拒绝回答的能力)

同样的事情也发生在DALL·E 3上。普通用户最早能够使用到的基于DALL·E 3的服务,其实是微软 Bing 的图像生成器。

微软刚刚宣布DALL·E 3上线 Bing 的前几天,网友们都玩的很欢。然而,不知从哪一天开始,网友们发现,活着的美国总统画不出来了,Xbox 怪兽不能毁灭城市了,飞机也不能飞掠世贸大楼了。

参与过Be My Eyes虚拟助手测试的网友也表示,ChatGPT 中最终推出的 GPT-4V 模型的拒绝回答情况要比测试期间常见得多。

再强大先进的模型,对你的要求只能输出一句「抱歉」,又何尝不是经历了「前额叶摘除手术」的样子呢。

视觉+插件:未打通的生态,可期待的未来

本次 ChatGPT 更新,将视觉和绘图功能都作为独立的 GPT-4 模型提供,这意味着用户不能够将这些新功能与原有的插件/联网/高级数据分析功能共同使用。

可能造成误解的是,GPT-4的高级数据分析(原称 Code Interpreter)功能虽然一直以来接受图片文件作为输入,但并不具备像 GPT-4V 那样读懂图片的能力。作为「代码解释器」,它能做的不过利用代码处理文件而已。

我试图曲线救国,手动把不同功能打通,一窥未打通的生态后的未来世界。

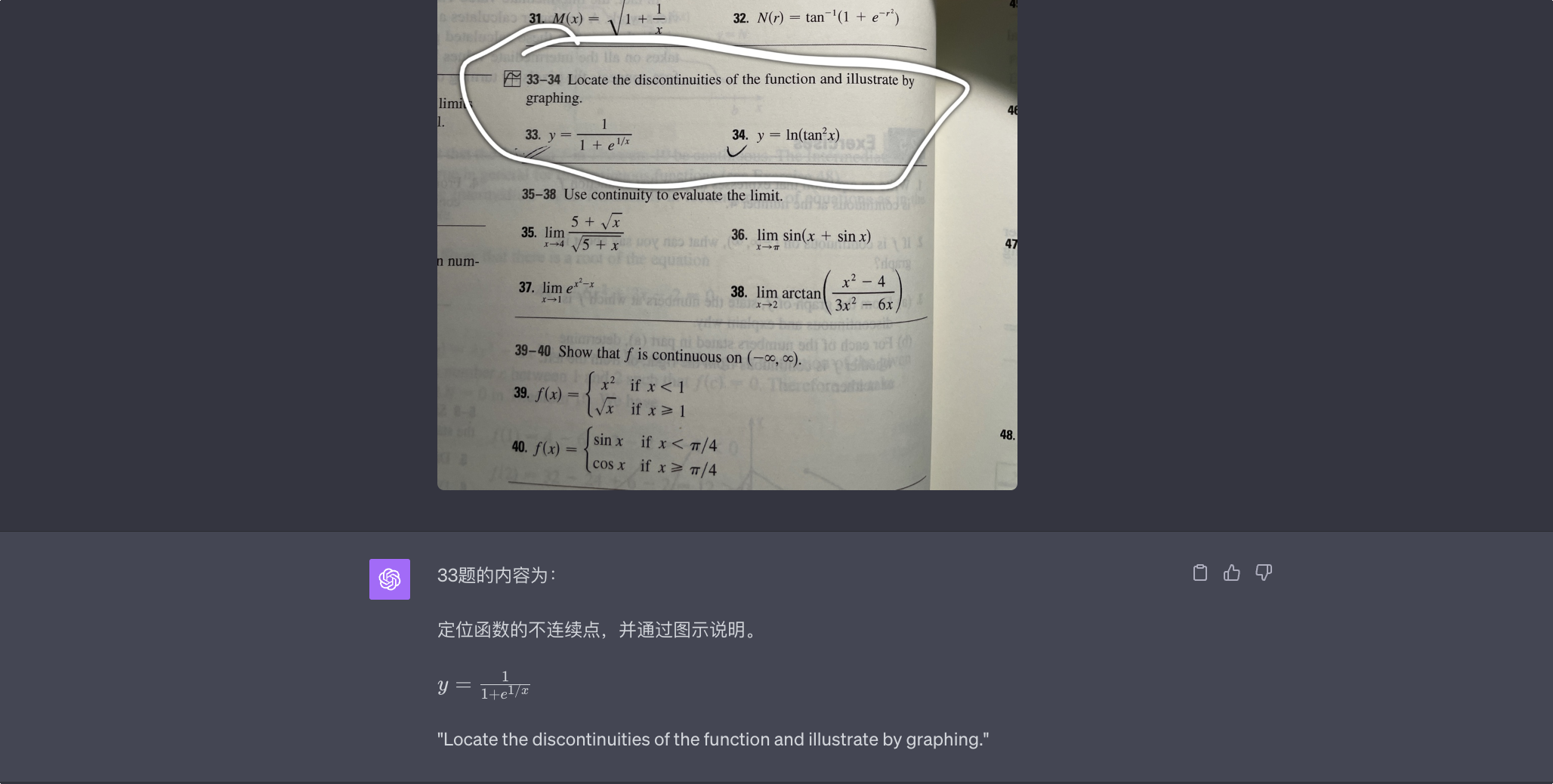

一个很实用但是可以让人 wow 出来的例子,通过 GPT-4V 识别数学题,再丢给 Wolfram 插件计算。

于是,你的 ChatGPT 就摇身一变,成了一个包教包会的知识渊博的老师。

当然啦,如果你直接让 ChatGPT 解数学题,大概率还是做不出来,但是有了 Wolfram 提供的答案,ChatGPT 大多数时候还真能把步骤讲得头头是道。毕竟它什么方法都懂,它只是不会计算。

像极了曾经对着答案写数学题的你。

不曾预料的后续:GPT-4 (All Tools)前瞻与展望

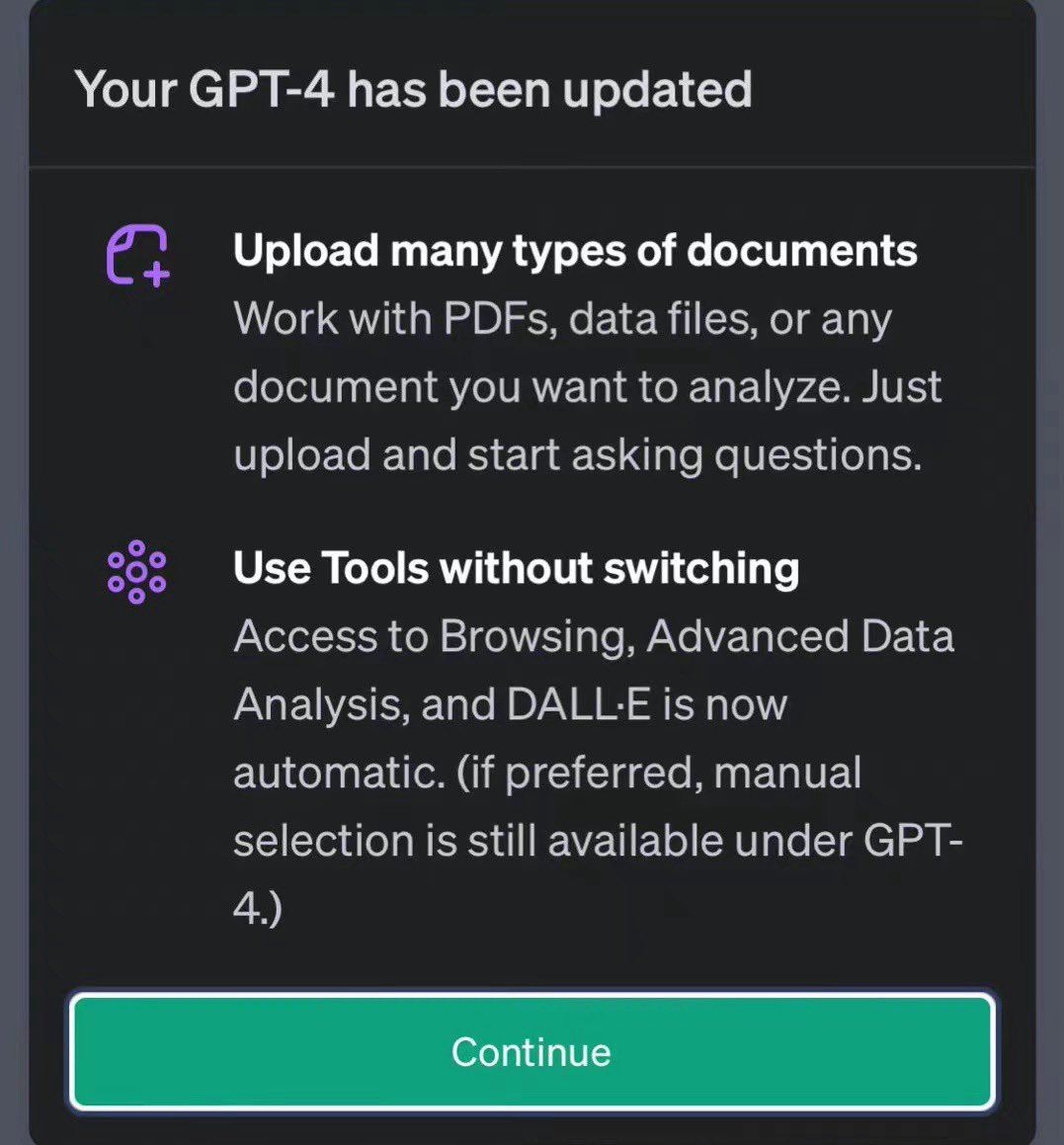

因为网站维护以及一些个人原因,这篇稿子大概拖了三个星期。结果没成想 OpenAI 的迭代不等人,竟然已经真的开始打通 GPT-4 的各种模型了。

大约 10 月 28 日开始,在国外社交平台上,就有网友放出了内测中的GPT-4 (All Tools)界面。

在这个暂时被称为GPT-4 (All Tools)的功能中,OpenAI 将 ChatGPT 的 Browsing、Advanced Data Analysis以及DALL-E 3功能整合到了一起,还加入了文件输入的功能,这使得模型能够自行决定调用何种模块执行任务。

虽然目前还没有网友的截图包含视觉功能,而且网友明确提及当前版本的GPT-4 (All Tools)不支持插件调用(也无法确定这一功能是否最终在GPT-4 (All Tools)中可用),但GPT-4 (All Tools)的形态的确与我在上文提到的那个「未打通的生态」非常接近。

展望未来,GPT 的形态一定是向着多功能的「Agent」的形态进化,而不只是停留在陪你聊天的层面。

这么一想,Siri 似乎才是那个最适合 GPT 的工位。

除「小站背面」外,本文另独家授权少数派(sspai.com)发布。其他渠道转载请注明来源。

博客写得很好,很喜欢“前额叶摘除手术”这个说法

国内用不了